Google最近發表了一款名為ScreenAI的新模型,這款模型能夠理解並解釋使用者介面和資訊圖表。 ScreenAI的原型是Google的視覺語言模型PaLI,ScreenAI在其基礎上進行了改進,採用了圖片轉文字模型pix2struct的彈性區塊處理策略,這種策略使得ScreenAI具備了處理不同長寬比圖像的能力。 此外,Google還附加了一套特殊的資料集和任務組合進行訓練,以此強化ScreenAI的圖表解讀能力,使其成為目前最先進的圖表解讀工具。

ScreenAI是一款集視覺和語言處理能力於一體的模型,它的任務是理解使用者的介面和資訊圖表。 ScreenAI的基礎架構是PaLI,它由多模態編碼器(Multimodal Encoder)和自回歸解碼器(Autoregressive Decoder)組成。 PaLI編碼器使用視覺Transformer(ViT)來創建圖像嵌入,並結合文字嵌入,使得ScreenAI能夠同時理解圖像和相關的文字訊息。

值得一提的是,ScreenAI採用了pix2struct模型的彈性區塊處理策略。 這意味著ScreenAI能夠處理不同長寬比的影像。 研究人員解釋說,這與傳統的固定網格模式有所不同,彈性區塊處理策略的網格尺寸能夠保留輸入影像的原始長寬比,因此可以提升模型對不同類型影像的處理能力。

ScreenAI的訓練過程分為兩個階段,第一階段是預訓練階段,第二階段是微調階段。 在預訓練階段,ScreenAI採用自我監督學習自動產生資料標籤,這些標籤被用來訓練ViT和語言模型。 而在微調階段,ViT的參數會被凍結,大部分使用的資料由人工評估員手動標記,以此微調模型,提升其在特定任務上的表現。

ScreenAI的訓練資料集主要來自不同裝置的螢幕截圖,包括了桌上型電腦、手機和平板電腦。 這種豐富的資料來源確保了資料集在視覺樣式、佈局配置和使用者介面元素的多樣性方面具有廣泛的覆蓋範圍。 研究人員使用基於DETR模型的佈局註解工具,識別並標記出各種使用者介面元素,例如圖像、象形圖(Pictogram)按鈕、文字以及空間關係等。

而像形圖則會透過專門的分類器進行進一步的分析,該分類器能夠區分77種圖示類型。 對於分類器未覆蓋的資訊圖表和圖像,ScreenAI會使用PaLI圖說模型產生符合上下文資訊的描述性文字。 此外,圖片上的文字也會經過OCR引擎識別,與註解文字結合,創造出每個螢幕截圖的詳細描述。

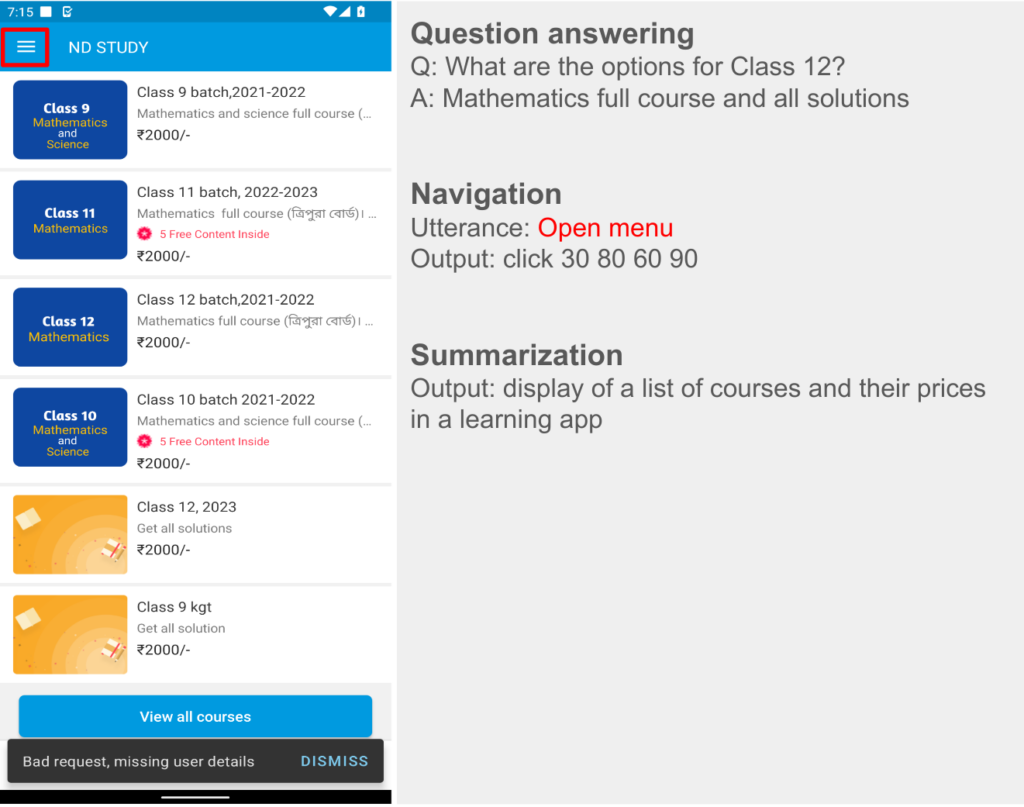

註解工具產生的螢幕描述文本,也需要經過語言模型PaLM 2進行強化,以增加資料的多樣性,才能成為最終的訓練資料集。 PaLM 2會根據截圖的描述以及問題回答、螢幕導航和螢幕總結等任務,產生輸入與輸出資料對。 例如,根據店家資訊的截圖描述,產生「餐廳何時開門?」的問題和相應的答案。 由於PaLM 2能夠根據不同類型的任務和互動,創建多樣化和更全面的資料集,因此ScreenAI能夠更好地理解和回應各種使用者的需求和行為。

儘管ScreenAI僅擁有50億參數,但其效率非常高。 在處理使用者介面和資訊圖表相關任務WebSRC和MoTIF時,與目前規模相近的先進模型相比,ScreenAI獲得了最高的分數。 而在圖表問題回答相關的任務Chart QA、DocVQA和InfographicVQA方面,ScreenAI也是目前同類模型中表現最佳者。 這些成績表明,ScreenAI在理解使用者介面和資訊圖表方面的能力已經處於行業領先水平。

Source : iTHome